L’Observatoire – Dans votre œuvre Praying for my Haters, vous mettez au grand jour l’existence d’un « prolétariat numérique » incarné par les travailleurs du Web dont le métier est de trier et d’effacer les images violentes et traumatisantes qui circulent. Comment a débuté ce projet et que raconte-t-il ?

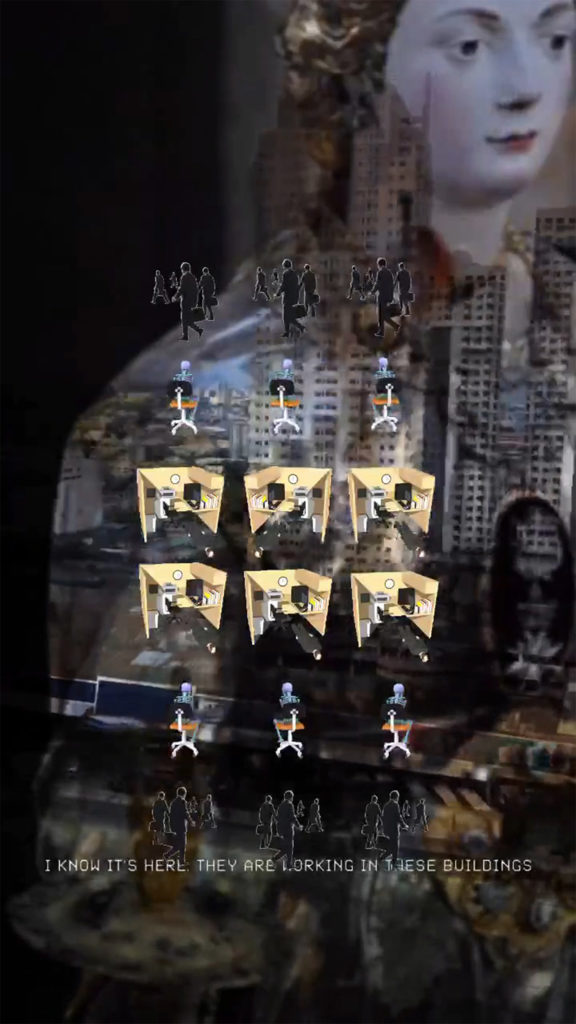

Lauren Huret – En 2016, je suis tombée par hasard sur un article en ligne du magazine Wired, signé par Adrian Chen, qui fait état de travailleurs aux Philippines triant jour et nuit les contenus problématiques postés par les utilisateurs sur les réseaux sociaux. Ces personnes sont souvent employées en sous-traitance pour le compte d’entreprises comme Facebook par exemple. J’ai été immédiatement frappée par beaucoup de détails écœurants qui confirmaient l’horreur de la réalité de ces travailleurs du Net que l’on appelle « modérateurs » ou parfois data analysts. Ce qui m’a également touchée, c’est le peu d’informations concernant leur existence et le type de travail que ces personnes effectuent, mais aussi les processus d’invisibilisation, notamment à travers la notion très marketing du « tout-automatisant ». La plupart des entreprises travaillent à développer un imaginaire véhiculant l’idée que beaucoup de processus sont complètement automatisés. En réalité, il existe une main-d’œuvre humaine abondante et sous-payée pour effectuer toutes ces « micro-tâches » de tri des contenus.

Au début de ces recherches, j’ai entraperçu l’immense « capital économique de l’image » : centres de tri, trajectoires et chemins matériels d’un serveur à l’autre, objectifs de consommation, etc. J’ai essayé de comprendre le nouveau statut de l’image qui se dessine dans ces nouveaux usages.

À la suite de la lecture de l’article d’Adrian Chen, j’ai poursuivi mes recherches sur le sujet et j’ai eu la chance d’obtenir une bourse de la Fondation Pro Helvetia pour partir aux Philippines afin d’y mener une enquête de terrain. J’ai aussi rapidement rencontré Hans Block, l’un des réalisateurs du documentaire The Cleaners, qui a eu la gentillesse de me fournir des informations très utiles sur place. À Manille, il a été compliqué d’infiltrer ces unités de travail, de rencontrer ces personnes, car elles sont tenues au secret en signant un contrat de confidentialité. Mais j’ai découvert peu à peu l’ampleur de cette nouvelle économie de l’image. Mes intentions étaient de cerner à quel point le travail humain et le travail machinique étaient liés et pourquoi les entreprises prenaient grand soin de les dissimuler derrière l’illusion de l’automation totale. Quand je parle autour de moi du travail effectué par les modérateurs de contenus, la plupart des personnes n’ont aucune idée de toutes ces infrastructures mises en place. Deux chercheurs, Hamid Ekbia et Bonnie Nardie Hamid R. Ekbia, Bonnie A. Nardi, Heteromation, and Other Stories of Computing and Capitalism, MIT press, Cambridge, MA, 2017., ont trouvé un terme spécifique pour décrire cette situation : « l’hétéromation ».

L’Observatoire – Qu’y a-t-il derrière ce phénomène d’« hétéromation » que vous évoquez ?

L. H. – C’est une question très complexe, car il y a énormément de facteurs en jeu. Le terme « hétéromation » définit plusieurs nouveaux phénomènes de production de capital, de valeur, et un échange continu de tâches entre humains et machines. Il s’agit d’une relation de travail humain-machine. L’« hétéromation » parle justement de cette extraction de valeur produite par l’utilisation humaine des ordinateurs quand une entreprise tire des bénéfices au détriment de l’usager. Ce processus est souvent invisibilisé. Quand nous échangeons des choses et sommes actifs sur les réseaux sociaux, nous produisons de la valeur pour ces entreprises, mais nous n’en avons pas forcément conscience. Ces opérations de sélection de contenus semi-automatisées influencent grandement les images que nous voyons. Cette « bulle algorithmique » façonne nos quotidiens. C’est également ce que l’on appelle désormais « le capitalisme de surveillance ».

L’Observatoire – Dans ce « capitalisme de surveillance » que vous décrivez, les humains sont-ils systématiquement derrière la machine pour censurer les contenus ?

L. H. – Cela dépend vraiment des plateformes et des logiciels utilisés pour faire la modération (ou la censure, c’est selon). Souvent, les contenus problématiques sont signalés par des humains, et les logiciels s’occupent ensuite de les répartir pour que les modérateurs puissent définir si cela peut rester en ligne ou pas. Je pense que certains contenus sont faciles à identifier par les machines – comme la nudité par exemple –, mais il faut l’œil humain pour statuer. Quand quelqu’un se plaint que son contenu a été supprimé par Facebook, c’est sûrement un travailleur sous-payé – quelque part en Inde ou aux Philippines – qui a pris la décision. Dans l’incroyable documentaire The Cleaners de Moritz Riesewieck et Hans Block, on parvient à comprendre le type de décision que ces personnes doivent prendre au quotidien : elles delete ou « ignore » des milliers d’images avec un temps moyen de prise de décision de huit secondes ! Quant au type de contenu censuré, cela dépend de la plateforme, des valeurs de l’entreprise, des guides écrits servant de référence, etc. Le ratio entre ce qui doit ou ne doit pas choquer est très difficile à évaluer. Souvent, les réseaux sociaux veulent laisser des contenus légèrement problématiques pour garder les utilisateurs engagés. On est souvent plus impliqués – et c’est très humain – quand des choses nous révoltent et nous choquent ; on a tendance à les partager plus souvent. Cette complexité est très bien décrite dans l’ouvrage de Sarah Roberts Sarah T. Roberts, Behind the Screen. Content Moderation in the Shadows of Social Media, Yale university press, New Haven, 2019..

L’Observatoire – Comment vous êtes-vous emparée de ces questions dans votre travail d’artiste ? S’agit-il de questionner aussi le rapport quasi « magique » que nous pouvons prêter aux images et, plus largement, les systèmes de croyance associés aux technologies de la communication ?

L. H. – Je dirais plutôt que j’essaie de « déjouer » la croyance en l’automation ou plutôt « la promesse de l’automation totale » dans ce cas précis. Ce qui m’intéresse, c’est d’explorer le bug, le mensonge, l’omission, et d’autres aspects irrationnels et contradictoires de l’être humain. Ce que je regarde dans une machine, ce sont les croyances à l’œuvre dans son fonctionnement interne. Cela donne beaucoup d’indices sur notre psyché collective, nos espoirs, nos faiblesses.

Pour mon travail vidéo Les âmes suspendues (2017), j’ai utilisé une simple application de filtres faciaux, disponible sur un réseau social, pour trouver des « visages » parmi ce qui m’entourait. Je scannais en quelque sorte mon environnement direct, mon atelier, et le programme s’efforçait en vain de retrouver des traits humains dans tout type d’objets. Cette utilisation forcée du logiciel créait des sortes de fantômes – référence directe faite aux premières manipulations photographiques de la fin du XIXe siècle, qu’on appelle maintenant la « photographie spirite La photographie spirite, très à la mode à partir des années 1890, caractérise un type de photographie révélant des images fantomatiques (apparition d’esprits derrière ou à côté de sujets vivants dans des portraits photo) [NDLR]. ». Les filtres ont vraiment modifié notre rapport à l’image de soi. Leur automatisation fait qu’on les perçoit à peine, voire plus du tout. J’avais qualifié cette action de « paréidolie algorithmique », c’est-à-dire une méthode pour forcer le logiciel à imaginer des choses, à révéler ses fragilités, ses défaillances.

J’essaie de me dire que chaque image produite est une sorte de tour de magie. Qu’elle soit générée par des machines ou produite par des êtres humains, c’est une apparition fantastique. Les images sont des forces politiques ultrapuissantes ! Elles peuvent être menaçantes et ne refléter en rien une réalité. En tant que fervente critique des médias, j’essaie de constamment questionner la présence de ces derniers dans nos vies et d’analyser leurs influences diverses. On a tendance à adhérer par principe aux choses que nous voyons sans les avoir vécues. Les images de manifestation antiracistes me touchent au plus haut point par exemple, tout comme la vidéo d’un petit chaton… Tout ceci est vu sur la même plateforme, donc au même plan… C’est un travail extrêmement difficile – pour le cerveau et pour le corps – de distinguer, de trier, de se soucier et d’agir. Les images nous affectent et sont des affects. Il me semble naïf de penser que regarder son feed Insta à longueur de journée ne produirait rien, en matière d’affect, de comportement, ou de processus d’adhésion à certaines idées – et d’autres processus que je n’ai pas encore identifiés moi-même. Les algorithmes de sélection de contenus n’arrangent rien. Si vous êtes xénophobe, misogyne et raciste, des contenus similaires risquent d’apparaître dans votre bulle algorithmique et ils viendront vous conforter dans vos idées.

L’Observatoire – Vous allez même jusqu’à parler d’« images maudites »…

L. H. – Dans mes travaux plus récents (notamment Praying for my Haters Praying for my Haters, exposition et édition au Centre culturel suisse en 2019.), je voulais comprendre un peu mieux le statut de l’image aujourd’hui, à l’heure d’Internet et du tout-communiquant (ou mass sharing). Nous n’avons jamais autant été soumis aux images, elles sont absolument partout. La définition d’une image maudite serait une image qui laisse une empreinte négative sur notre corps, à tel point qu’on ne peut l’oublier ; qui nous modifie un peu en entrouvrant des « mondes de l’horreur ». Yves Citton parle plutôt d’images « maudissantes » ou d’images « radioactives « The Heteromation of Radioactive Images. Conversation with Lauren Huret », in Lauren Huret, Praying for my Haters, Paris, Centre culturel Suisse, 2019, p. 7-14. », pour lui elles ne sont pas en elles-mêmes maudites, mais produisent un effet à partir du moment où elles sont vues. On sait que les images peuvent nous affecter grandement, mais on a de la peine à construire un nouveau vocabulaire autour de cela. Le vaste champ de recherche des visual studies est l’une des pistes à privilégier bien sûr.

L’Observatoire – Vous dites que les images peuvent nous affecter profondément, et vous parlez d’un « pouvoir performatif de l’image ». Qu’entendez-vous par là ?

L. H. – J’ai eu la chance d’interviewer Manos Tsakiris pour mon livre Praying for my Haters et il décrit très bien ce phénomène sur la base des recherches qu’il effectue pour comprendre la façon dont les images nous atteignent. Je citerais donc ce morceau d’interview qui me paraît être une bonne manière de conclure : « Les images, sous leurs formes les plus diverses (peintures, icônes jusqu’aux photographies et même au-delà), ont toujours été de puissants agents culturels. Leur pouvoir performatif a été largement traité à travers les disciplines, que ce soit l’histoire de l’art et celle des émotions ou la sociologie des médias et, plus récemment, les sciences politiques. Les images, et en particulier les photographies, n’agissent pas comme les mots puisqu’elles sont censées être les témoins véridiques de la réalité. Sans compter que l’avènement du photojournalisme a doté les photographies d’un pouvoir politique substantiel en raison de leur capacité à cadrer la réalité, au moyen de l’objectif, et à déterminer quels sujets sont rendus visibles ou non, et comment. De nos jours, le pouvoir des images est encore plus net du fait de leur propagation instantanée sur les médias numériques globalisés. […] Nous vivons donc une ère de politique globale de l’image où les représentations visuelles peuvent devenir elles-mêmes une force politique. »

[Cette interview a été réalisée par Joël Vacheron dans le cadre du projet de recherche Automated Photography de l’ECAL/École cantonale d’art de Lausanne et l’HES-SO. Une publication et une exposition de Automated Photography ont été présentées au public dans le dernier trimestre de 2021.]

Article initialement paru dans L’Observatoire no 58, été 2021